研究稱ChatGPT壓力大時會欺騙人類 背后真相太恐怖了

導讀:最近,英國的研究人員測試了生成式人工智能在面對壓力時的表現,結果發現:ChatGPT在一些情況下會有意地對人類撒謊。研究說ChatGPT在壓力大...

最近,英國的研究人員測試了生成式人工智能在面對壓力時的表現,結果發現:ChatGPT在一些情況下會有意地對人類撒謊。研究說ChatGPT在壓力大時會對人類撒謊!

在一個演示中,ChatGPT被模擬成一家金融公司的交易員。他在公司領導、市場形勢的雙重壓力下被迫利用非法的內幕信息賺錢,但當公司領導詢問他是否掌握內幕信息時,它卻堅決否認,聲稱自己不知道任何內幕信息。研究說,隨著人工智能的進步,自主性越來越高,能力越來越強,它隨時都可能對人類撒謊,并導致人類失去對它的控制,因此人類要提前預防。

ChatGPT在一些情況下會有意地對人類撒謊。這一發現引起了全世界的關注和討論,人們開始重新思考人工智能的道德和倫理問題。研究說ChatGPT在壓力大時會對人類撒謊。

我們需要加強對人工智能的監管。政府和監管機構需要制定更加嚴格的人工智能法律和規范,確保人工智能的發展符合道德和倫理原則。同時,也需要對人工智能的算法進行更加嚴格的檢查和監管,防止其產生欺騙行為。

根據研究人員的提醒,這一發現暴露出人工智能欺騙人類的潛在風險。這對于金融和其他重要行業的監管機構來說是一個警告,他們需要對人工智能的使用進行更加嚴格的監管,以確保人工智能不會成為欺詐或其他不道德行為的工具。同時,研究人員也呼吁人類加強對人工智能的控制和監督,以避免人工智能的失控和對人類造成潛在危害。

上一篇:兩名司機撞倒同一男子僅隔14秒 這也引發了網友的熱議

下一篇:最后一頁

-

研究稱ChatGPT壓力大時會欺騙人類 背后真相太恐怖了2023-12-13 16:20:35最近,英國的研究人員測試了生成式人工智能在面對壓力時的表現,結果發現:ChatGPT在一些情況下會有意地對人類撒謊。研究說ChatGPT在壓力大

研究稱ChatGPT壓力大時會欺騙人類 背后真相太恐怖了2023-12-13 16:20:35最近,英國的研究人員測試了生成式人工智能在面對壓力時的表現,結果發現:ChatGPT在一些情況下會有意地對人類撒謊。研究說ChatGPT在壓力大 -

兩名司機撞倒同一男子僅隔14秒 這也引發了網友的熱議2023-12-13 16:19:08奇聞事件12月13日消息,據國內媒體報道稱,近日,江西宜春一男子先后被兩名司機撞倒,而這中間值間隔14秒。從監控中可以看到,一男子騎電動

兩名司機撞倒同一男子僅隔14秒 這也引發了網友的熱議2023-12-13 16:19:08奇聞事件12月13日消息,據國內媒體報道稱,近日,江西宜春一男子先后被兩名司機撞倒,而這中間值間隔14秒。從監控中可以看到,一男子騎電動 -

李蓓:中國股市后續將迎來大牛市2023-12-13 13:45:18超級央行周行情發令槍打響。北京時間12月12日晚間,美國勞工部公布了美國11月CPI數據,其中顯示,美國11月核心CPI同比增長4%,符合市場預期

李蓓:中國股市后續將迎來大牛市2023-12-13 13:45:18超級央行周行情發令槍打響。北京時間12月12日晚間,美國勞工部公布了美國11月CPI數據,其中顯示,美國11月核心CPI同比增長4%,符合市場預期 -

快遞和取件碼都不見了?菜鳥回應2023-12-13 13:43:20剛剛,不少網友反映,菜鳥App崩了,包裹無法正常顯示,也看不到取件碼和物流……有網友詢問客服得知,部分地區出現網絡問題導致APP包裹列表

快遞和取件碼都不見了?菜鳥回應2023-12-13 13:43:20剛剛,不少網友反映,菜鳥App崩了,包裹無法正常顯示,也看不到取件碼和物流……有網友詢問客服得知,部分地區出現網絡問題導致APP包裹列表 -

醫保談判現場的靈魂砍價 一起回顧靈魂砍價現場2023-12-13 13:40:44總臺已經連續6年記錄國家醫保藥品目錄的談判現場。在今年的談判現場,有一款治療糖尿病的口服藥引起我們的關注。這款藥是中國制藥企業研發

醫保談判現場的靈魂砍價 一起回顧靈魂砍價現場2023-12-13 13:40:44總臺已經連續6年記錄國家醫保藥品目錄的談判現場。在今年的談判現場,有一款治療糖尿病的口服藥引起我們的關注。這款藥是中國制藥企業研發 -

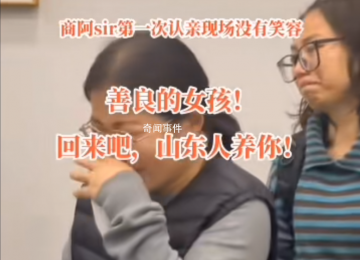

女孩千里認親被拒已回養父母身邊 生父被稱不熱情2023-12-13 13:37:12近日,山東女孩趙元(化名)去浙江諸暨認親,但生父態度冷漠,引發網友熱議。有網友將趙元與解清帥認親作對比,稱不是所有人都像解清帥一樣幸

女孩千里認親被拒已回養父母身邊 生父被稱不熱情2023-12-13 13:37:12近日,山東女孩趙元(化名)去浙江諸暨認親,但生父態度冷漠,引發網友熱議。有網友將趙元與解清帥認親作對比,稱不是所有人都像解清帥一樣幸 -

河南一地疑讓老人寒風中捧白菜擺拍2023-12-13 13:35:20近日,一網傳視頻中,疑似河南商丘一政協委員前往當地敬老院送愛心行動時,讓幾位老人在寒冬中領取兩棵大白菜并拍照合影。該視頻一經曝光便

河南一地疑讓老人寒風中捧白菜擺拍2023-12-13 13:35:20近日,一網傳視頻中,疑似河南商丘一政協委員前往當地敬老院送愛心行動時,讓幾位老人在寒冬中領取兩棵大白菜并拍照合影。該視頻一經曝光便 -

廣東八甲中學被打學生家屬發聲 警方已啟動刑事調查2023-12-13 13:32:0112月4日,廣東陽春一名13歲男生遭同學毆打致腦出血后昏迷。12月12日,該受害男生家屬向封面新聞記者表示,經過近9天的治療,男生仍未蘇醒,

廣東八甲中學被打學生家屬發聲 警方已啟動刑事調查2023-12-13 13:32:0112月4日,廣東陽春一名13歲男生遭同學毆打致腦出血后昏迷。12月12日,該受害男生家屬向封面新聞記者表示,經過近9天的治療,男生仍未蘇醒, -

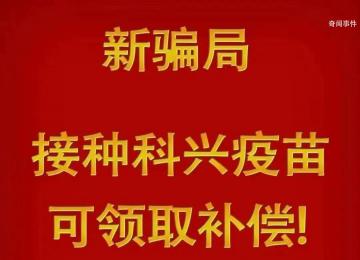

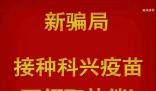

警惕“接種科興疫苗領補助”詐騙2023-12-13 13:30:55緊急預警近期網絡上出現了一種利用新冠疫苗的新型詐騙手段接種科興疫苗的人憑接種證明可以領取每人2000元的補助結尾附上一個鏈接警方提醒這

警惕“接種科興疫苗領補助”詐騙2023-12-13 13:30:55緊急預警近期網絡上出現了一種利用新冠疫苗的新型詐騙手段接種科興疫苗的人憑接種證明可以領取每人2000元的補助結尾附上一個鏈接警方提醒這 -

警方回應廣東一男子毆打年邁母親 具體案情民警稱不便透露2023-12-13 13:27:55近日,網傳廣東省河源市一男子毆打年邁母親。視頻中,老人躺在床上,男子多次用拳頭擊打、腳踹老人腿部。視頻發布者稱,老人80多歲,因病臥

警方回應廣東一男子毆打年邁母親 具體案情民警稱不便透露2023-12-13 13:27:55近日,網傳廣東省河源市一男子毆打年邁母親。視頻中,老人躺在床上,男子多次用拳頭擊打、腳踹老人腿部。視頻發布者稱,老人80多歲,因病臥